Czy warto czekać na iPhone'a ze wsparciem dla technologii HDR?

O technologii HDR słyszymy coraz częściej. Co kryje się jednak pod tym tajemniczym skrótem, którego producenci używają mówiąc nie tylko o aparatach, ale też konsolach, telewizorach, a nawet smartfonach? Dziś postaram się przybliżyć Wam temat technologii High Dynamic Range towarzyszącym trzem ostatnim z wymienionych urządzeń.

Telewizory wspierające technologię HDR są już od jakiegoś czasu dostępne na rynku, ale większe zainteresowanie tematem przyniosła dopiero zeszłoroczna premiera zmodernizowanych konsol Sony i Microsoftu – PlayStation 4 Pro oraz Xboxa One S. Właściwości ekranu to bowiem jedna kwestia, ale to co możemy na nim wyświetlić ma także duże znaczenie. Dlatego też o ile ekran może być przystosowany do odtwarzania materiałów przygotowanych z myślą o technologii HDR, ale to rola twórców gier i filmów, aby stworzyć odpowiedni materiał.

Warto w tym momencie dodać, że ważne z punktu widzenia konsumentów działania w tym temacie robi Netflix. Aplikacja mobilna tego serwisu otrzyma wkrótce wsparcie dla technologii HDR oraz Dolby Vision. Skorzystać będą z niej jednak mogli przynajmniej na razie wyłącznie użytkownicy LG G6. Z czasem do tej listy dołączy z pewnością Samsung Galaxy S8 oraz Sony Xperia XZ Premium... i miejmy nadzieję, że także iPhone 8.

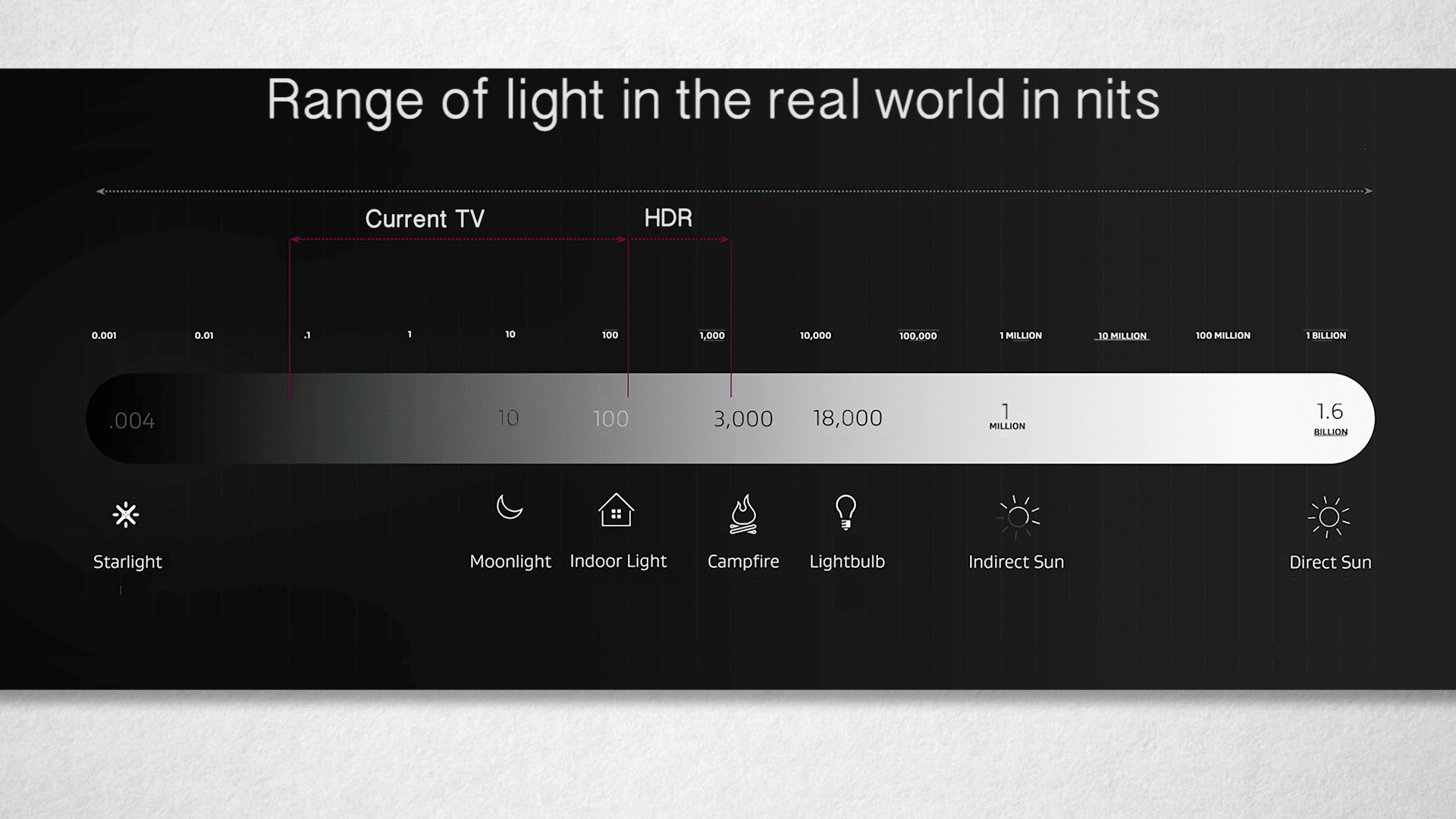

Ideę przyświecającą stworzeniu technologii HDR było zapewnienie użytkownikom takich wrażeń wizualnych, jakich doświadcza w codziennym życiu dzięki swoim oczom i ogólnym postrzeganiu rzeczywistości. Natura jest nam w stanie dostarczyć absolutnej czerni (0 nitów), światło księżyca (0,01 nitów), światło żarówki (100 nitów), rozproszone światło słoneczne (1 milion nitów) i wreszcie bezpośrednia światło słoneczne (1,6 miliardów nitów). Ludzkie oko jest w stanie zarejestrować światło od około 0,01 nitów do 10 tysięcy nitów i to ideał, do jakiego zmierza technologia HDR.

Standard kinowy oddaje od 0,01 nitów do około 60 nitów, a standardowe telewizory dostępne obecnie na rynku od 0,1 nitów do 100 nitów. Wszystko sprowadza się do tego, że gdy spojrzymy w stronę słońca w upalny dzień, to zostaniemy oślepieni. Widzimy też różnicę w jasności księżyca, żarówki, halogenu i światła rozproszonego. Niestety telewizory – przynajmniej na razie – mają problem z osiąganiem bardzo niskich i bardzo wysokich wartości jasności, a ponadto słabo różnicują poziom natężenia światła.

Producentom gier i filmów zależy, aby w toku przygotowywania i postprodukcji materiałów, dynamika światła jak najmniej traciła na swojej wartości względem tego, co jesteśmy w stanie zobaczyć w rzeczywistym świecie. Tak przygotowane materiały musimy oglądać na odpowiednich telewizorach, które będą w stanie pokazać bardzo jasne punkty, a jednocześnie zachować te wyjątkowo ciemne – oczywiście bez osiągania efektu „przepalenia” obrazu i zamiany czerni w szarość, co możemy osiągnąć zmieniając ustawienia kontrastu i jasności nawet na zwykłym filmie oraz zdjęciu.

Problem dotyczący zakupu telewizora wspierającego technologię HDR jest taki, że wielu producentów – szczególnie mniej renomowanych – bazuje na spełnieniu wymogów standardów... jaki sobie sami określili. Warto więc zwracać uwagę przede wszystkim na modele, które otrzymały certyfikat UltraHD Premium przyznawany przez UHD Alliance. Należy też zwrócić uwagę na fakt, że mamy na rynku do czynienia z dwoma standardami charakteryzującymi się wysokim kontrastem i dynamiką światła. Pierwszy zakłada, że telewizor musi wyświetlić jasność conajmniej 1000 nitów i pokazać też najciemniejsze punkty przy jasności 0,05 nitów (przede wszystkim ekrany LCD). Dla drugiego standardu te wartości to zaś 540 nitów i 0,005 nitów (przede wszystkim ekrany OLED).

Niestety nie udało mi się znaleźć danych dotyczących zakresu jasności dla ekranów trzech wspomnianych wyżej smartfonów. Jedynie LG informuje, że w przypadku modelu G6 postawiono na standard Dolby Vision.

Technologia HDR ma jednak związek nie tylko z jasnością, ale też z kolorem. Warto więc znowu zacząć od możliwości ludzkiego oka, które jest swego rodzaju ideałem, który stanowi wyznacznik dla producentów monitorów, telewizorów, rzutników, gier i smartfonów. Powyżej możecie zobaczyć zakres kolorów, jakie widzi człowiek – model ten jest oczywiście uproszczony i większość z Was nie zobaczy go w taki sposób, w jaki został przygotowany. Wszystko za sprawą tego, że dominująca część monitorów bazuje na standardzie sRGB/rec.709, choć na przykład graficy i fotografowie wykorzystują zazwyczaj ekrany o szerszej gamie kolorów. Podobnie sprawa wygląda w kwestii iPhone’a 7 oraz nowych MacBooków Pro – w ich przypadku ten „trójkąt” też jest większy, gdyż Apple zastosowało standard DCI-P3.

No i właśnie DCI-P3 jest tym, czym charakteryzują się ekrany HDR, które otrzymały certyfikat UltraHD Premium. Docelowy plan zakłada zaś osiągnięcie gamy Rec. 2020, choć to na razie relatywnie odległa przyszłość. Reasumując jednak – ekrany z HDR pozwolą nam zobaczyć więcej kolorów, szczególnie odcieni zielonego i błękitnego. Do tej pory ekrany wyświetlały taką samą barwę dwóch punktów spoza gamy sRGB, które w rzeczywistości różniły się od siebie. Ludzkie oko zobaczyłoby subtelną różnicę między nimi, ale telewizor „spłycał” to do barwy, którą był w stanie wyświetlić.

Oczywiście przestrzeń kolorów to nie wszystko. Ona dotyczy wyłącznie zakresu barw, jaki towarzyszy danemu standardowi. Osobno należy rozpatrzyć kwestię bitów, czyli liczby odcieni, które telewizor wyświetla, jeśli mieszczą się one w gamie kolorów, jakie wspiera. W sRGB mamy więc trzy kolory – czerwony, zielony niebieski (red, green, blue) – i 8 bitów. Każdy kolor przyjmuje więc 2^8 wartości – od 0 do 255, co w sumie daje 16 milionów kolorów. Weźmy jednak dwa punkty – ciemno szary i jasno szary. Im więcej bitów, tym więcej odcieni zobaczymy między nimi. Jeżeli bity będą dwa, to zobaczymy tylko jasno szary i ciemno szary. Jeżeli bitów będzie pięć, to zobaczymy jasno szary, delikatnie jasno szary, szary, delikatnie ciemno szary i ciemno szary. To oczywiście pewne uproszczenie, ale oddaje istotę całego problemu.

Ze względu na fakt, że standard DCI-P3 obejmuje więcej kolorów, to bitów musi być więcej, aby przyjścia między barwami były płynne. Dlatego też standard HDR to nie 8, ale 10 lub 12 bitów. Pozwala to na uzyskanie odpowiednio 2^10=1024 punktów przejścia albo nawet 2^12=4096 punktów przejścia. Tak więc wyświetlanie kolorów bazuje na pokazaniu trzech wartości. Przy sRGB jasno zielony będzie oznaczony jako (173,255,47), żółty – mieszanina zielonego i czerwonego (255,255,0), a niebieski (0,0,255). Przy większej liczbie bitów – przykładowo 12 – ten sam niebieski miałby zaś współrzędne (0,0,4095), bo z innym wierzchołkiem trójkąta gamy dzieliłoby go więcej odcieni.

Rozwój technologii HDR jest z całym pewnością dobrym trendem i cieszę się, że również Apple pracuje nad doskonaleniem swoich ekranów. Pozostaje mieć nadzieję, że proces ten się utrzyma i sprawi, że wyświetlacze naszych iPhone'ów, Maców i iPadów otrzymają wsparcie dla HDR. Mam jednak przeczucie, że nastąpi to dopiero w momencie pojawienia się matryc OLED w smartfonach firmy z Cupertino, czyli wraz z premierą iPhone'a 8.